01委员基本情况

02委员简介

李成龙,安徽大学人工智能学院教授,博士生导师,主要从事计算机视觉与深度学习方面的研究工作,至今在IEEE TPAMI、IEEE TIP、IEEE TNNLS、IEEE TCYB等国际权威期刊上发表学术论文30余篇,在CVPR、ECCV、AAAI等国际顶级会议发表论文10余篇。获得授权国家发明专利12件,其中1件实现重要科技成果转化。曾获安徽省教学成果奖一等奖(第一完成人)、安徽省计算机学会青年科学家奖、安徽省计算机学会自然科学奖一等奖、安徽省计算机学会科技进步奖一等奖、安徽省人工智能学会学术会议最佳论文奖、ACM中国合肥优秀博士论文奖等。主持国家基金委面上项目和青年项目、安徽省自然科学基金杰出青年项目(重点)、中国博士后科学基金特别项目等。担任中国图象图形学学会视觉大数据专委会委员,国际顶尖期刊Nature、IEEE TPAMI等审稿人和国际顶级会议CVPR、ICCV、ECCV、AAAI、ACM MM等程序委员会委员或审稿人。

03委员亮点工作

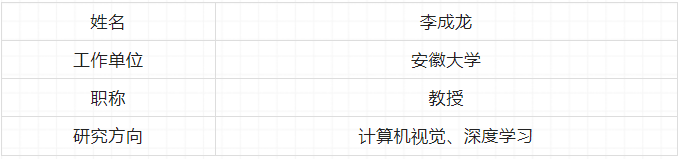

以车为中心的视觉分析。目前,众多的汽车虽然给人们带来了许多便利,但也增加了城市交通道路的负担,行车安全面临着严重挑战,而且问题愈演愈烈。然而,现有工作主要聚焦以人为中心的视觉分析研究,以车为中心的视觉分析相关的深入研究相对较少,而遮挡、视角差异等因素为车辆视觉分析带来极大挑战,严重制约了该领域的研究和发展。为此,我们深入开展以车为中心的视觉分析研究,主要工作包括四个方面(如图1所示)。在非标车牌识别方面,提出了解耦生成框架,通过对背景图像和非标车牌文本图像的解耦生成,极大提高了生成数据的多样性和真实性,有效扩充了面向非标车牌识别的训练数据,一定程度上解决了该方向的小样本问题和长尾分布问题;在车辆属性识别方面,提出了一种基于多任务卷积神经网络的车辆属性识别方法,根据车辆类型识别结果设计图像掩模,去除和车辆颜色属性不相关的区域特征,以此同时实现车辆颜色和类型的准确识别;在遮挡感知方面,根据遮挡状态的发生规律设计了若干遮挡模式模板和自适应集成机制,在遮挡状态未知的情况下实现遮挡感知的鲁棒视觉分析;在车辆重识别方面,提出了属性引导的车辆重识别框架,通过基于属性的特征增强和扩张技术提高相似属性下的不同车辆图像之间的判别性,通过基于视角的特征减弱和收缩技术消除视角差异对同一车辆不同视角成像的影响。相关工作发表在IEEE TIP、IEEE TITS、IEEE TCSVT,相关成果获得了安徽省计算机学会科技进步奖一等奖,相关专利实现了科技成果转化,作价300万元入股公司。

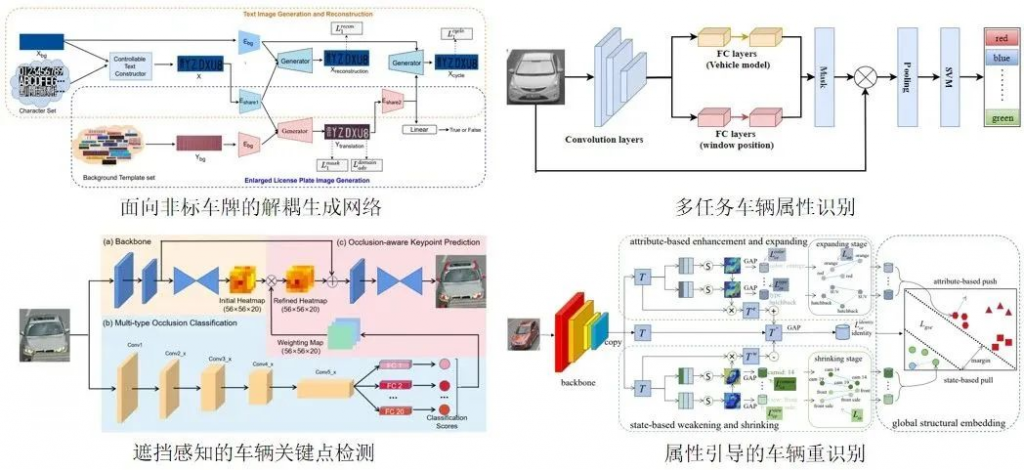

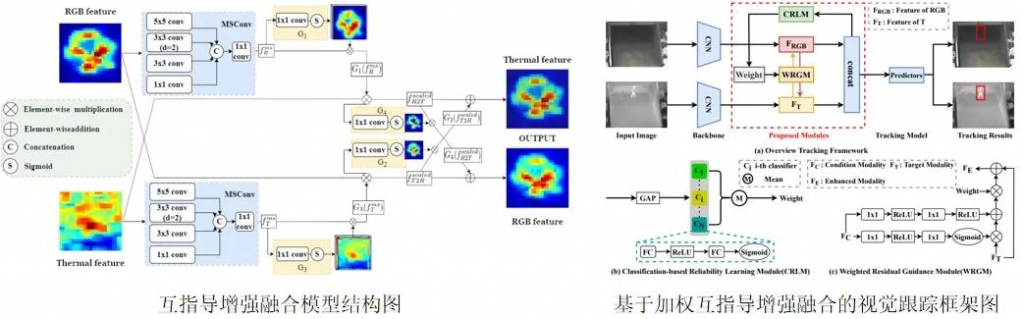

多模态增强融合感知。现有视觉感知系统依赖传统摄像头单一模态视觉信息,其成像在复杂场景和环境因素(如黑夜、雾霾和恶劣天气)下的质量急剧下降,甚至失效,极大限制了视觉感知算法性能。我们引入红外成像,利用其对光线变化不敏感、对烟雾的穿透能力强等成像优势,与可见光成像形成较强的优势互补,能够有效克服了现有视觉系统中的感知盲区,开创了一系列多模态融合感知研究新领域,包括可见光-红外目标检测、可见光-红外视觉跟踪和可见光-红外目标重识别。多模态视觉信息复杂多样,为有效融合带来极大挑战。一方面,多模态视觉数据具有一定的不精确性,对事物的判断不具体或模棱两可,且数据不完整也会使得解释和推理变得困难。另一方面,多模态视觉数据具有一定的不一致性,可能会对同一目标做出相互矛盾的解释,若不能有效处理,融合算法可能会得出错误结论。针对多模态视觉数据的不精确性和不一致性等难点,我们提出了质量感知和互指导增强的多模态融合方法(如图2所示),通过自适应的双向指导学习,有效挖掘不同模态的判别特征以及抑制噪声信息,极大提高了多模态表征能力。特别地,该多模态增强融合方法能够充分利用包含低质量模态的有用特征,对视觉感知性能大幅度提升起了关键作用。下图展示了两种互指导增强融合模型结构,相关论文发表在CVPR、AAAI、ECCV、IEEE TNNLS、IEEE TIP、IEEE TCSVT。

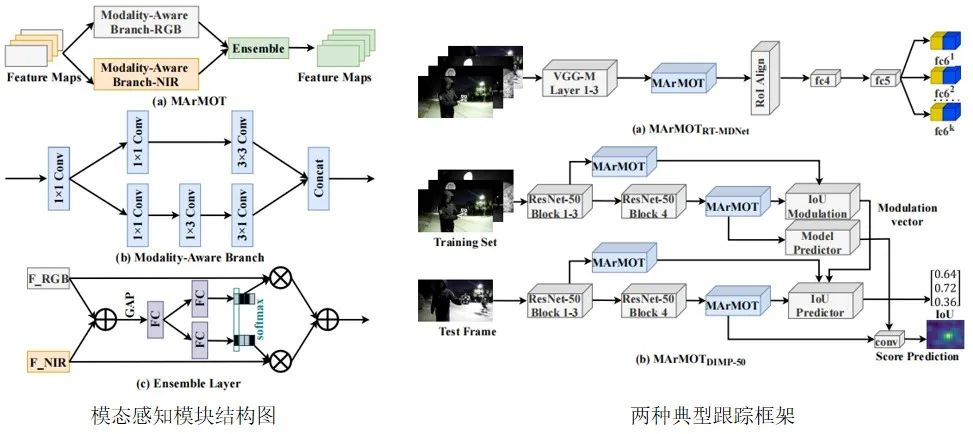

跨模态视觉跟踪。基于可见光数据的单模态目标跟踪研究已经取得了很大进展,但在复杂场景和极端条件下,一些目标的外观特征在弱光条件下是微弱的甚至是不可见的,因此极大限制了跟踪性能。引入深度和红外等其他模态数据是处理单模态成像缺陷的有效方法,但多模态成像平台通常需要精心设计,并且此类设备价格昂贵,目前还不能满足实际应用需求。近年来,近红外成像逐渐成为许多监视相机的重要组成部分,其成像可以根据光照强度在可见光和近红外之间切换。这两种模态是异构的,具有不同的视觉特性,为目标跟踪带来了巨大挑战。因此,我们提出了一种新的跨模态视觉跟踪任务,主要工作包括两个方面(如图3所示)。第一,构建了跨模态视觉跟踪数据集,包括654个跨模态视频序列,共超过48万帧,为该方向的研究和发展提供一个统一的评测基准。第二,提出了一种基于模态感知模型的跨模态视觉跟踪方法,使用两个并行的卷积神经网络分支提取目标外观的特定模态特征表示;设计了一个集成模块,自适应地聚合两个分支的输出特征,消除可见光和近红外模态之间的特征分布差异,以此解决输入模态不可知问题。我们在两个典型视觉跟踪框架中验证了模态感知模型的有效性,相关论文发表在AAAI。

04委员专访

(1)请问您的研究领域包括哪些?最近进展如何?

目前,我的研究领域主要包括以车为中心的视觉分析及应用和多模态融合感知。在以车为中心的视觉分析及应用方面,我们团队主要做了车辆关键点检测、非标车牌识别、车辆属性识别和车辆重识别等工作,形成了“3D精确定位-细粒度识别-跨模态匹配”的车辆数据感知与表示模式,解释了城市中车与车之间的深层时空关联关系。相关成果发表在本领域国际权威期刊上,并已经应用于合肥市交通超脑和铜陵市交通超脑,取得了良好的应用效益,相关科研项目“以车为中心的视觉分析及应用”受到了安徽省杰青项目(重点)资助。在多模态融合感知方面,我们团队提出了一系列互指导增强融合方法,极大提高了多模态表征能力,显著提升了在公共数据集上的性能。但公共数据集一般基于空间对齐和信息完整的假设下构建,而在真实应用场景中,平台和成像等因素的影响会导致模态空间不对齐和模态缺失,现有方法很难或无法处理这两个问题。我们团队最近针对空间不对齐和模态缺失问题展开深入研究,取得了一定的进展,这将为多模态融合技术的落地应用奠定基础。

(2)请向我们科普一下您研究领域相关的一项技术在应用中的具体体现。

公路治超是一个世界性难题。过去,国内对于车辆超限的检测主要以静态称重、人工甄别和人工测量为主,传统治超存在人为干扰因素多、易造成测量不准确、影响交通通行效率、建设成本高等局限性。我们团队紧贴国家“智慧交通”战略发展需求,突破了非限制复杂路面不停车情况下运输车辆的属性识别技术和重识别技术,可以快速、精准、非接触、安全可靠地对车辆进行定位、识别、跟踪与测量,完善了跨模态、跨平台视觉信息与称重信息数据的异构融合与协同体系,实现了从传统的称重治超到智慧超限治理的升级,开创了新一代人工智能技术在道路交通管理中落地应用的新范例。2020年,我们团队以知识产权作价的方式增资入股进入合肥市正茂科技有限公司,目前已经在安徽省等10个省份超过1500条车道成功实施应用,市场占有率达到80%以上。

(3)您对您未来的工作有什么展望?

在未来工作中,我们主要聚焦三个方面的研究工作。第一,继续深入开展以车为中心的视觉分析研究工作,解决面向智能交通和安全监控等行业应用的视觉感知难题。第二,解决多模态融合感知中的难点问题,包括但不限于空间不对齐和模态缺失问题,推进该领域相关技术的落地应用。第三,探索和开展人工智能交叉方向的研究工作,产出原始创新强、国际影响力高的科研成果。