第十九届中国图象图形学学会青年科学家会议

神经网络架构论坛成功举办

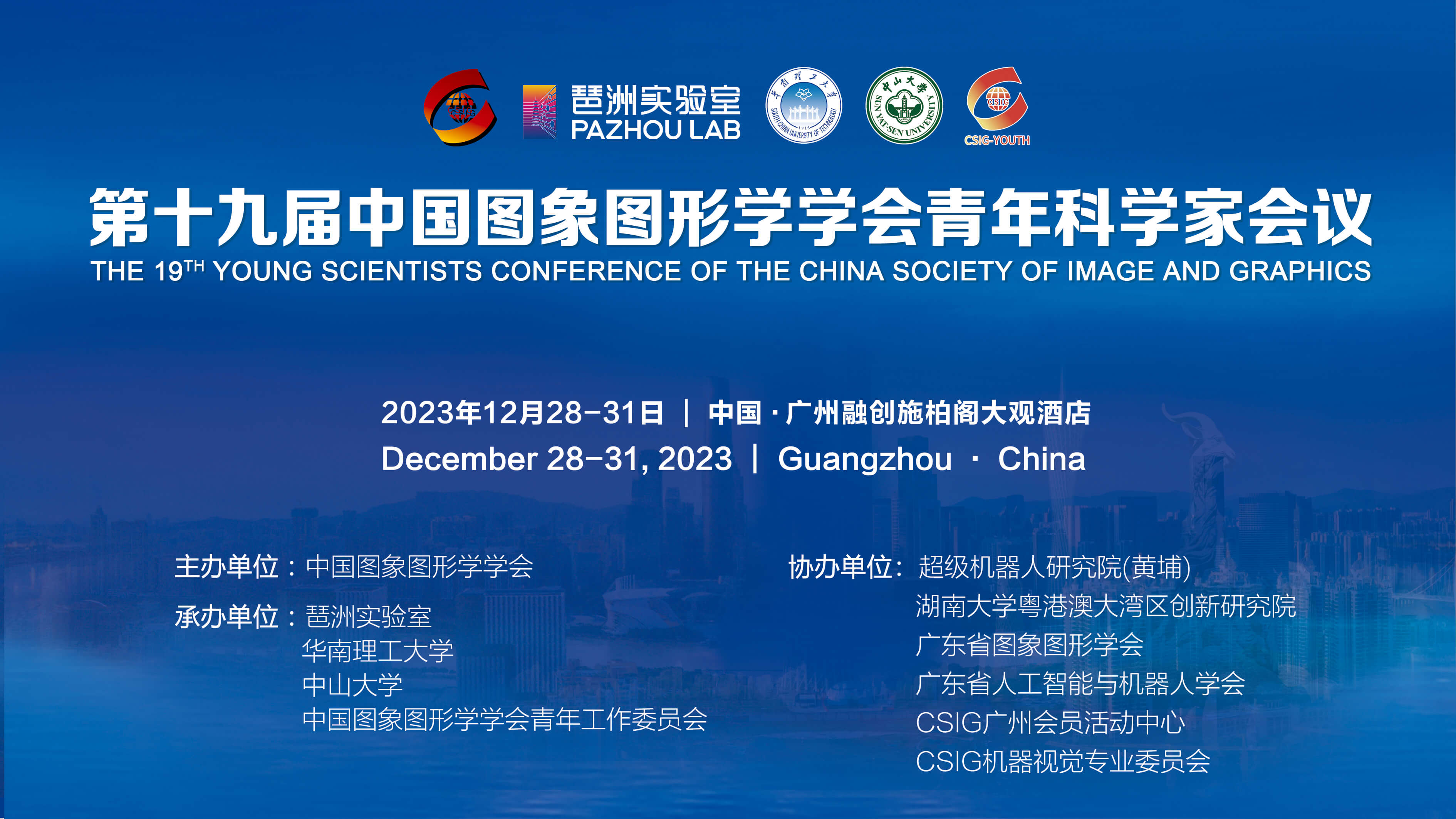

由中国图象图形学学会青年工作委员会发起的“第十九届中国图象图形学学会青年科学家会议”于2023年12月28-31日在中国广州召开。本次会议由中国图象图形学学会主办,琶洲实验室、华南理工大学、中山大学、中国图象图形学学会青年工作委员会承办。王耀南院士、谭铁牛院士、中山大学赖剑煌教授、华南理工大学徐向民副校长、许勇副校长、琶洲实验室常务副主任李远清教授、华南理工大学陈俊龙教授、北京大学林宙辰教授共同担任大会主席。

会议面向国际学术前沿与国家战略需求,聚焦最新前沿技术和热点领域,会议设4个大会报告,27个主题分论坛,4个Tutorial,总计近150场高水平学术报告 。2023年12月29日下午, 神经网络架构论坛成功举办。论坛由厦门大学纪荣嵘老师和厦门大学郑侠武老师联合组织,郑侠武老师担任本次论坛的主持人。论坛聚焦该领域的最新研究进展与前沿技术,详细探讨了 “视觉表征模型结构设计”、“视觉基础模型的高效结构设计与训练方法”、“基于知识蒸馏场景下的样本生成”、“探索神经网络架构的表示与理解”和““结构重参数化”与大核跨模态基础模型”等主题内容。

中国科学院大学特聘教授叶齐祥、清华大学副教授黄高、合肥工业大学教授王杨、悉尼大学副教授徐畅和腾讯AI Lab高级研究员丁霄汉几位专家,作为本场论坛讲者进行主题报告。

叶齐祥教授带来主题为“视觉表征模型结构设计”的报告,邀请博士生田运光进行汇报。分析了局部卷积运算与全局注意力运算的互补性及辩证关系,将局部特征与全局特征耦合形成Conformer网络结构,小规模模型可以显著增强视觉表征能力,提升表征模型的性能下限。探讨了局部卷积运算造成的Mask Image Modeling (MIM)自监督学习信息泄露问题,提出了Token Merging操作,突破卷积或局部运算的局部约束,形成高效分层Transformer 表征(HiViT)与全预训练的Transformer 金字塔网络(iTPN)。在ImageNet分类任务上,不依赖于额外数据,iTPN-Base, iTPN-Large, iTPN-Huge 分别达到了88.0%,89.2%, 89.7%的Top-1分类精度。系列研究从模型结构设计角度将视觉目标检测、分割等任务性能提升到了一个新高度。同时介绍了视觉模型结构设计的未来思路及其与自然语言语言模型的融合探索。

黄高副教授带来主题为“视觉基础模型的高效结构设计与训练方法”的报告。基于Transformer的大型视觉基础模型在计算机视觉领域获得广泛关注。然而模型深度和参数的迅速增加造成了训练和推理时间长、显存开销大、容易过拟合等挑战。本报告将从深度神经网络的模型和训练算法两方面介绍本团队在提升视觉基础模型计算效率方面的研究进展。在模型方面,报告介绍基于空间动态计算和线性注意力机制的视觉Transformer结构改进方法,以及基于模块化训练与组装的高效训练策略;在学习算法方面,根据神经网络学习过程的动态特性,利用“先易后难”的思想设计新型课程学习算法。上述工作为如何设计与训练高效的视觉大模型提供了新的思路与方法。

王杨教授带来主题为“基于知识蒸馏场景下的样本生成”的报告。近年来,基于数据安全与隐私问题,无数据场景下的知识蒸馏方法获得了越来越多的关注。然而,现有方法侧重于恢复原始数据,忽略了生成样本对于学生模型的适应性,在涉及老师-学生网络模型存在较大差异的情况下,仍然面临着诸多挑战。在本次报告中,首先通过以下几个问题介绍关于知识蒸馏的差异性研究:老师学生模型差异性为什么以及什么时候会影响学生的性能?如何衡量老师学生间的差异性?然后,立足无数据量化任务,通过泛化误差分析,深入研究孤立学生模型所导致的欠拟合、过拟合问题。围绕生成样本的适应性,首次提出零和博弈观点进而分析无数据量化,解决了模型差异性问题,同时为生成样本构建上下边界,通过边缘优化,在无数据蒸馏过程中实现理想样本的生成。

徐畅副教授带来主题为“探索神经网络架构的表示与理解”的报告。深度神经网络由互相连接的节点(神经元)层组成,它们处理和转换数据以执行各种机器学习任务,如图像识别、自然语言处理等。神经架构决定了这些层次的结构、神经元的连接方式以及数据如何在网络中流动。报告重新探讨了卷积神经网络的基本要素,并探讨了实现网络中的最小计算单元的替代方法。在神经架构搜索的背景下,深度神经网络的拓扑结构变成了一个优化参数。报告介绍了各种用于架构优化的实际目标,使用大型语言模型来解释和深入了解神经网络的架构。

丁霄汉研究员带来主题为“‘结构重参数化’与大核跨模态基础模型”的报告。“结构重参数化”(Structural Re-parameterization)是报告人提出的一种神经网络模型的通用方法论,其核心在于通过模型参数的等价变换实现模型结构的等价变换,从而提升模型的性能或为模型引入某些性质。这一极为简单但实用的方法论在最近两年中得到了广泛的应用,包括通用模型(RepVGG、RepLKNet、FastViT、RepViT、Non-deep Network)、目标检测(YOLOv6、YOLOv7、PP-YOLO)及更多其他领域(RepNAS、RepSR)。本次报告将介绍这一方法论的来由、基本理念、发展脉络与代表性的成功应用。

本次论坛为青年科学家们提供了宝贵的学术交流平台,为神经网络架构的研究进展提供了新的启示和思想碰撞。