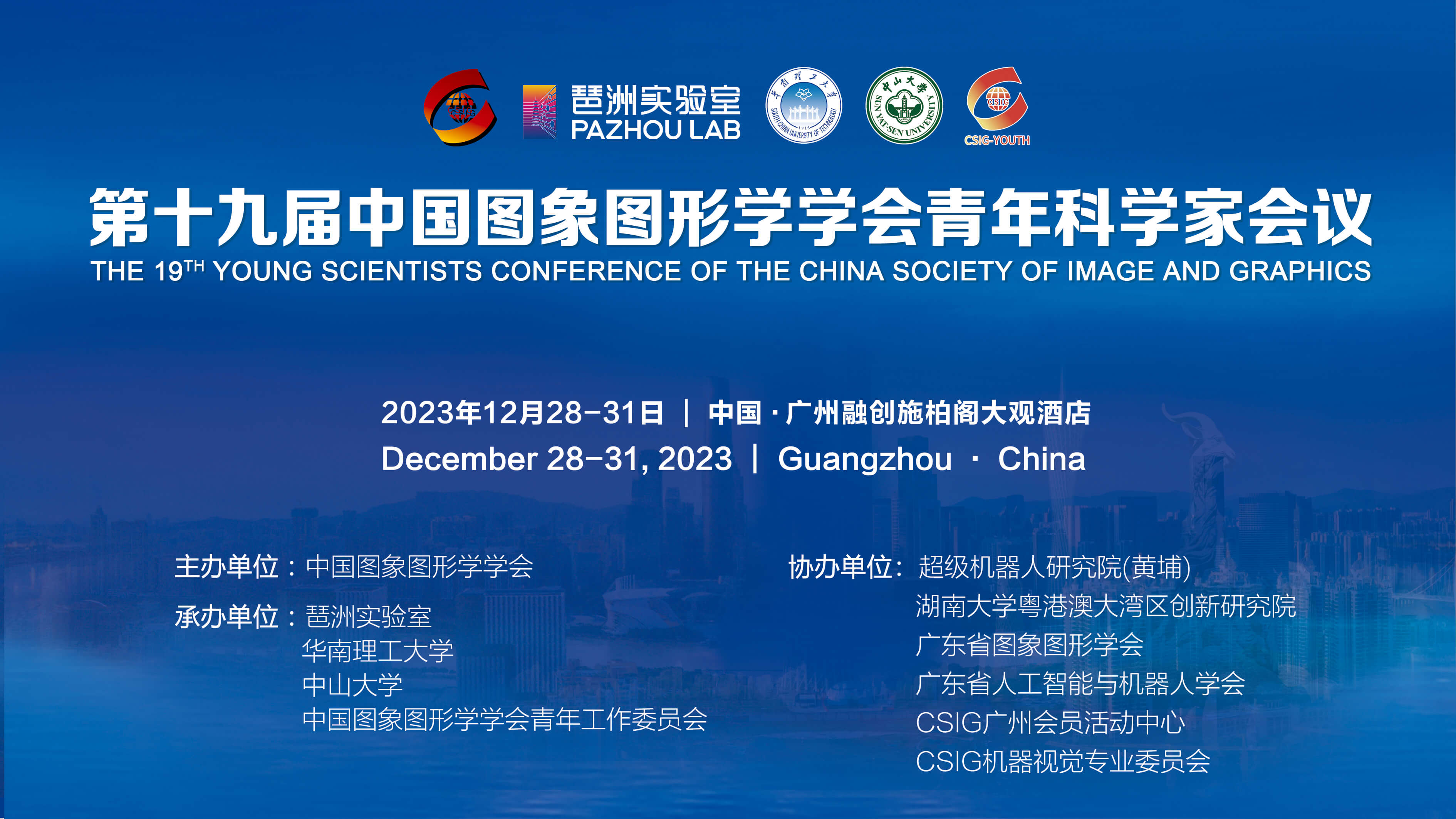

第十九届中国图象图形学学会青年科学家会议

AIGC生成式人工智能论坛成功举办

由中国图象图形学学会青年工作委员会发起的“第十九届中国图象图形学学会青年科学家会议”于2023年12月28-31日在中国广州召开。本次会议由中国图象图形学学会主办,琶洲实验室、华南理工大学、中山大学、中国图象图形学学会青年工作委员会承办。王耀南院士、谭铁牛院士、中山大学赖剑煌教授、华南理工大学徐向民副校长、许勇副校长、琶洲实验室常务副主任李远清教授、华南理工大学陈俊龙教授、北京大学林宙辰教授共同担任大会主席。

会议面向国际学术前沿与国家战略需求,聚焦最新前沿技术和热点领域,会议设4个大会报告,27个主题分论坛,4个Tutorial,总计近150场高水平学术报告 。2023年12月29日下午, AIGC生成式人工智能论坛成功举办。论坛由赫然、李冠彬联合组织。论坛聚焦该领域的最新研究进展与前沿技术,详细探讨了“基于扩散模型的离线强化学习”和“扩散模型进展与AIGC前沿应用”等主题内容。

清华大学教授朱军、中山大学教授林倞、北京科技大学教授刘红敏、南京邮电大学教授鲍秉坤、哈尔滨工业大学教授左旺孟、南洋理工大学助理教授刘子纬几位专家,作为本场论坛讲者进行主题报告。

清华大学教授朱军带来主题为“基于扩散模型的离线强化学习”的报告。

离线强化学习(Offline RL)可以从预选收集到的行为数据中学习最优的决策策略,但如何有效刻画行为数据的分布是离线强化学习的一个关键问题。本报告将介绍基于扩散模型的离线强化学习若干进展,这类方法可以利用扩散概率模型的强大建模能力,估计行为数据的分布,同时,结合一些高效的强化学习算法,达到显著的性能提升。

中山大学教授林倞带来主题为“多模态感知与推理前沿进展”的报告。

近期,基于Diffusion生成式模型的多模态图像生成相关研究快速发展,并表现出令人惊艳的效果。尤其是,更加可控、快速适应新场景的个性化生成也受到了越来越多的关注。在本报告中,围绕可控及个性化图像生成问题,探讨基于扩散模型的生成图像可控性和多样性。个性化生成方面,提出one-shot文生图的DreamArtist模型,实现在仅用一张图像就可以快速学习新概念,并个性化生成图像反映参考图中实体特征及风格等;可控生成方面,一方面从Layout控制角度,提出LAW-Diffusion模型学习多物体空间组合语义的Layout Embedding,结合动态引导机制引导扩散模型的生成过程;另一方面,提出基于大语言模型的语义能力的SUR-adapter,来增强现有的预训练文本编码器,从而解决所发现的图文不匹配问题,提升生成质量与可控性。最后,构建一套系统化、模块化、可拓展性强的Diffusion模型训练与推理一体化框架,为当前相关基于扩散模型的图像生成研究提供系统化工具。

北京科技大学教授刘红敏带来主题为“扩散模型在视频感知任务中的应用”的报告。

扩散模型利用正向扩散过程系统地扰动数据中的分布,然后通过学习反向扩散过程恢复数据的分布,从而产生高度灵活且易于计算的生成模型,被广泛的应用于图像生成。

本报告从非图像生成任务的角度,介绍扩散模型在视频感知相关任务中的应用尝试,以拓展扩散模型的应用领域。具体地,基于扩散模型实现视频多目标跟踪(MOT)、时序动作定位(TAL)任务中位置/时间信息的准确估计:将多目标跟踪任务构建为从随机生成的噪声提议到不同跟踪物体框的去噪扩散过程,提出一种基于扩散模型的多目标跟踪方法;提出一种基于去噪扩散过程的精细视频动作定位(TAL)框架,通过使用中间噪声(预测值与GT之间的差距)来微调每一帧的预测结果,逐渐弥合预测与GT之间的差距,显著提高了动作定位的精度,缓解了TAL中的常见的边界模糊问题。通过上述典型任务应用,本报告拟进一步分析和讨论扩散模型在非生成任务中的优势和局限性。

南京邮电大学教授鲍秉坤带来主题为“跨模态图像生成”的报告。

近年来跨模态图像生成在图像生成、图像编辑等任务中取得了广泛应用。虽然现有研究已经在生成图像的质量上取得了一定的进步,但生成图片的速度较慢,且对硬件需求较高,主要原因在于:当前预训练生成模型具有庞大的参数规模,并且生成过程高度复杂,每个生成步骤需进行大量计算,导致整个生成过程耗时相当长。这一缺陷使得模型具有非常高的训练成本,且提高了用户的硬件和时间成本。本报告将首先介绍近期跨模态图像生成任务的研究进展,从提高预训练GAN模型生成质量且保证生成速度的角度出发,介绍团队在文本生成图像任务的研究思路和研究成果,最后探讨如何使用大规模预训练多模态模型优化文本到图像生成任务。

哈尔滨工业大学教授左旺孟带来主题为“文本引导的可控图像与视频生成”的报告。

近年来,Stable Diffusion等大规模文生图模型的出现为视觉内容生成提供了新的助力。然而,相对于通用图像生成,许多应用需求中都会涉及特定对象或特定结构的生成。为此,本报告主要包括:(1) 针对特定对象的定制化生成,综合利用全局伪文字生成和局部注意力匹配机制,设计了一种新的高效编码网络Elite生成伪文字,显著提升图像定制化生成效率,并研究了基于文本解耦的方式进行更好的伪文字生成。(2)针对特定结构的图像生成问题,提出了一种动态引导和开放域正则化方法,更够更为准确地利用分割图进行开放域图像生成。(3) 针对特定结构的视频生成问题,提出了一种仅基于已有Stable Diffusion,不需要额外训练的ControlVideo方法,能够更为稳定地生成视频。

南洋理工大学助理教授刘子纬带来主题为“大模型时代下的多模态AIGC”的报告,其邀请杨帅教授进行汇报。

当前,数字内容产业处于高速发展期,技术体系逐渐成熟,应用场景愈发丰富。其中,多模态AIGC是数字内容生成的基石,它实现了每一位参与者都能无需专家知识来创建属于自己的虚拟现实。而最近多模态大模型的涌现也为多模态AIGC带来了巨大的助益与机会。本次报告将介绍多模态大模型与神经渲染的最新成果,并从“人-物-景”三位一体体系以及通用生成角度来介绍MMLab@NTU在多模态AIGC方面的探索与进展。

本次论坛为青年科学家们提供了宝贵的学术交流平台,为AIGC生成式人工智能的研究进展提供了新的启示和思想碰撞。