报告摘要:大模型时代,数据极为关键。而开源、高质量、大规模的视频数据以及对应的视频描述是稀缺的。本次分享首先介绍一个面向高质量视频生成的数据集OpenVid-1M (ICLR 2025):1) 一个高质量的百万级文生视频数据集,最高支持1080p视频生成;2)提出了一种多模态视频DiT模型结构(MVDiT);3)在视频生成、视频复原、视频插帧、3D/4D生成等多个相关任务中被使用。其次介绍一个实例级精细视频描述的方法InstanceCap (CVPR 2025):1)首个用于文本到视频生成的实例感知结构化描述方法;2)将全局视频转化为实例,提升针对局部实例的准确描述;3)构建了一个包含2.2万个视频的InstanceVid数据集,提高描述与视频之间的保真度。最后介绍一个基于预训练文生视频模型先验的真实世界视频超分框架STAR (ICCV 2025),进一步提升视频分辨率和画质效果。

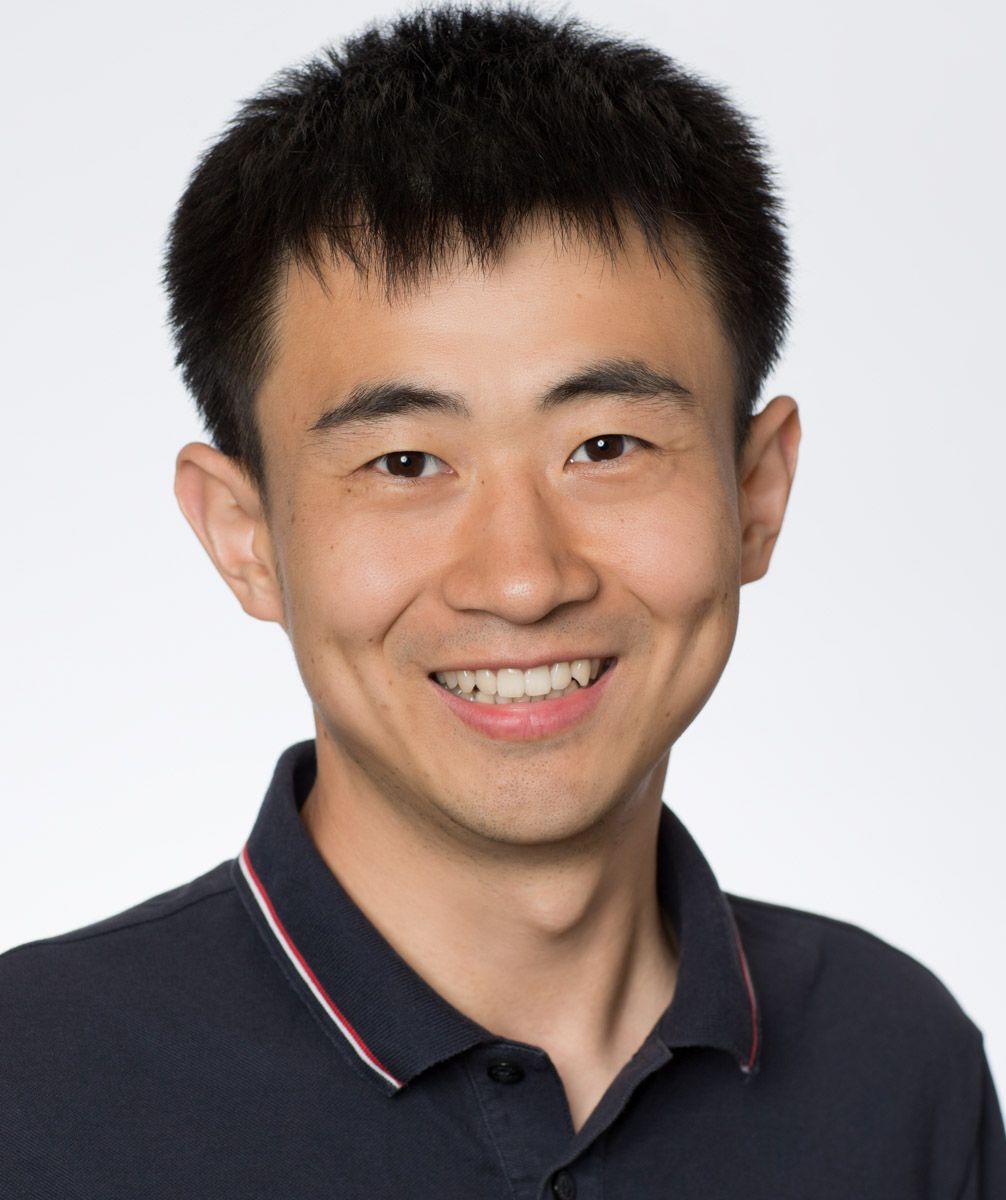

讲者简介:邰颖,南京大学智能科学与技术学院副教授,博导。入选姑苏创新创业领军人才计划项目(2024),南京大学紫金学者(2023)。主持国家自然科学青年基金、江苏省自然科学青年基金、南京大学-中国移动联合研究院生成方向项目(150万/年)、南京大学AI4S项目。课题组与字节、腾讯、阿里、中国移动、VIVO、Liblib AI等国内知名公司合作紧密。曾任腾讯优图实验室专家研究员(T12)及研究组长。主要研究方向为生成式计算机视觉技术,包括多模态图像/视频视觉生成、以人为中心的视觉感知和生成、以及高保真图像/视频修复等。目前在模式识别和计算机视觉国际权威会议、期刊(CCF-A类/JCR一区论文)已发表论文70余篇。谷歌学术被引用逾14,000次,两篇代表性一作论文分别被引用逾2,700次、2,000次;授权专利40余项。带领团队获得NTIRE 2020&2021三项超分赛道全球竞赛冠军。研究成果获得2021年江苏省科学技术一等奖(第四完成人),2018年度中国图象图形学会优秀博士论文提名奖。担任ECCV 2022,WACV 2023-2025,FG 2023会议的领域主席,Image and Vision Computing期刊副主编,入选斯坦福大学评选的全球Top 2%科学家(终身影响力榜单)。