CSIG中国图象图形学会-青年委员风采-胡建芳

发布时间:2024-08-03 14:36:42 人气: 作者:小编

【青年委员风采】- 胡建芳

简介:胡建芳,中山大学副教授,博士生导师。专门从事视频内容解析理论方法及应用研究,构建了异质特征同步学习和自动路径汇聚网络等视频学习理论算法,揭示了不同模态序列数据间存在结构关联的规律,阐明了不同时间进度视频存在的语义联系,实现了视频序列信息在时间、空间、模态、层次等维度的动态交互和紧致融合,在相关领域刊物发表学术论文50余篇。获广东省杰出青年基金支持,入选中山大学逸仙学者新锐学者,获中国图象图形学学会优秀博士学位论文奖、广东省自然科学奖二等奖,多次参加国际顶级学术会议挑战赛并获冠军,担任第十九届中国图象图形学学会青年科学家会议学术Poster主席、中国图象图形学学会视觉大数据专业委员会委员和中国图象图形学学会青年工作委员会委员等。

委员亮点工作介绍

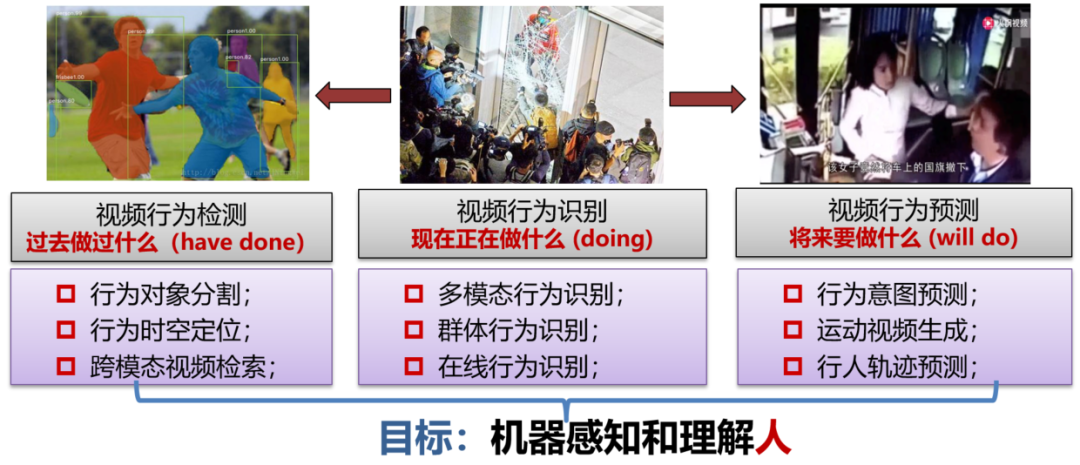

围绕理解视频全时域人体行为活动,胡建芳团队主要展开了视频行为检测、行为识别和行为预测等研究,分别研究视频中人过去做过什么,现在正在做什么和将来要做什么。

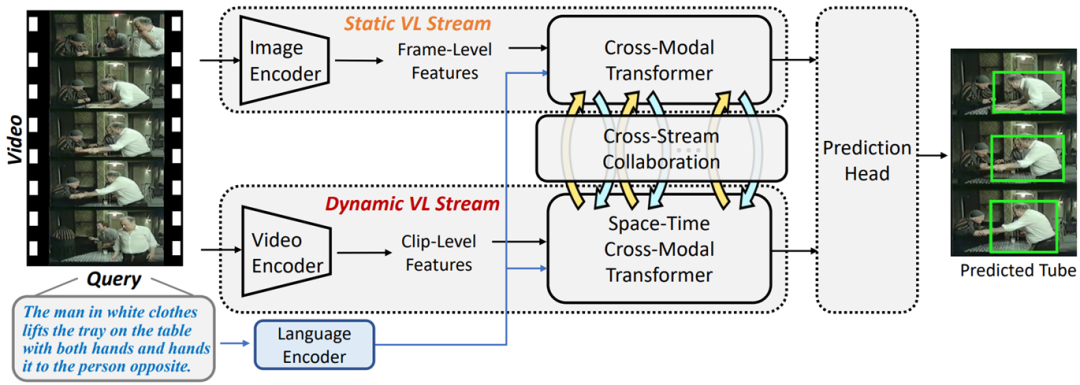

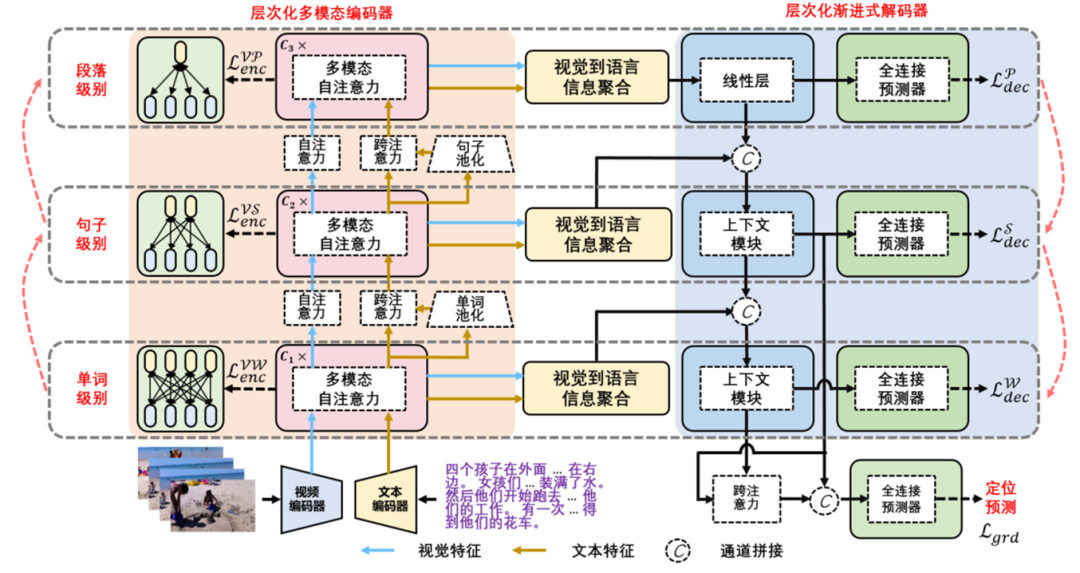

视频定位与检索旨在从长视频中定位和检索出与文本内容相符的事件片段,在视频监控、视频剪辑和人机交互中起着重要的作用。为使模型更准确地理解文本语、理解视频、并理解文本语义与视频之间的对应关系,胡建芳团队在挖掘视频与语言空间在不同层次语义关联方面进行了多项研究。具体研究和创新包括:1)提出了动静交互建模方法(如图1所示),实现动的视觉信息与动的文本信息匹配(动对动),静的视觉信息与静的文本信息匹配(静对静);2)多粒度语义对齐方法,该方法通过搭建层次对齐网络框架,采用递进式的层次编码和解码结构,分别从词、句、段三个粒度实现文本空间与视频空间的信息对齐;3)搭建了一个真假视频-文本对的双分支孪生网络框架,该框架接收真实视频-文本数据对和人工构造的视频-文本数据对输入,实现双分支协同学习。所提的网络架构如图所示,该方法在多个视频-文本定位数据集上取得了领先性能,获得了ACMM Workshop 2022举办的Person In context竞赛的冠军。

基于多模态特征动态融合的视频行为识别(现在正在做/发生什么)

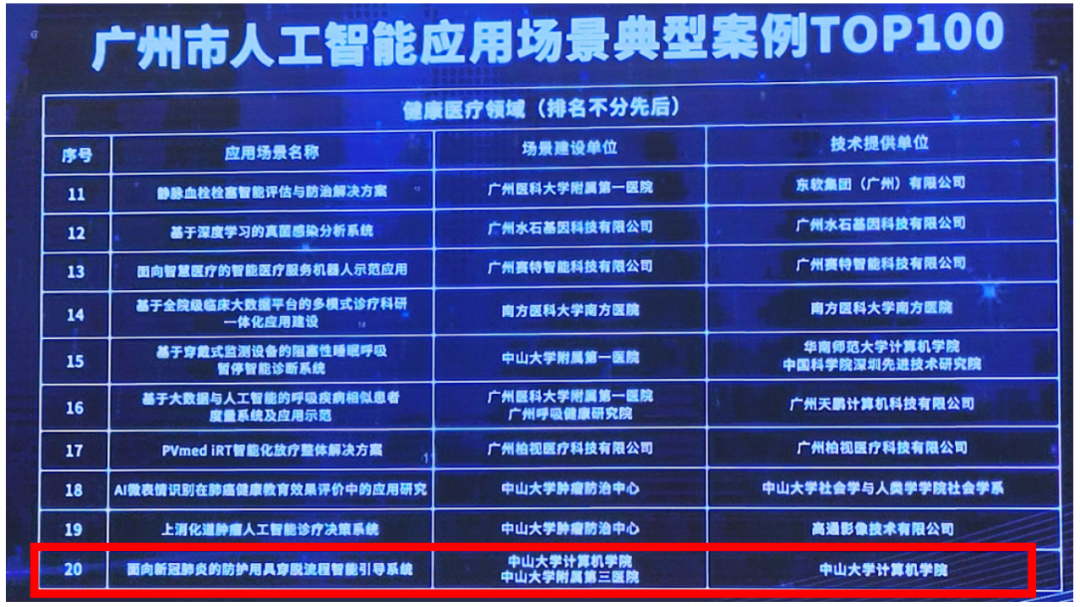

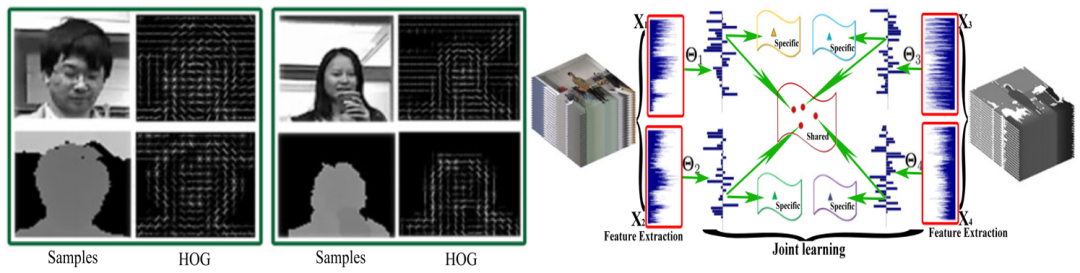

研究表明结合不同模态数据的互补信息,能够更准确地识别视频中正在发生的行为内容。但考虑到不同模态的视频/时序信息具有不同的特征表示结构和独有的信息表达特性,如何克服不同模态特征的异质性以及时域差异、挖掘多种模态特征跨时域的动态结构关联,从而实现多模态特征高效动态融合是本研究的难点。本工作主要发现不同模态视频行为数据间存在着跨时域和跨模态的结构关联,创新地搭建多模态异质特征同步学习和深度双线性等多模态特征融合学习框架,结合静态和动态视觉两个层面匹配不同模态信息,提炼多模态视频数据的跨模态跨时域结构关联,实现不同模态特征间的动态高效融合。具体创新包括:1)发现了不同模态数据之间并不是完全无关的,它们之间存在着一定的结构关联,并因此搭建了多模态异质特征同步学习框架,提取不同模态特征间的共享和私有结构成分,在共享和私有结构空间实现多模态特征高效融合;2)受双线性映射性质启发,搭建了深度双线性网络,以数据驱动的方式交替挖掘不同模态序列特征在时间和模态维度的线性关联。基于该研究成果,胡建芳研究团队搭建了新冠肺炎防护用具穿脱流程智能引导系统和理化生实验操作智能监测及打分系统,评为广州市人工智能应用场景典型案例TOP100。

图2. 基于多模态特征学习的视频行为识别

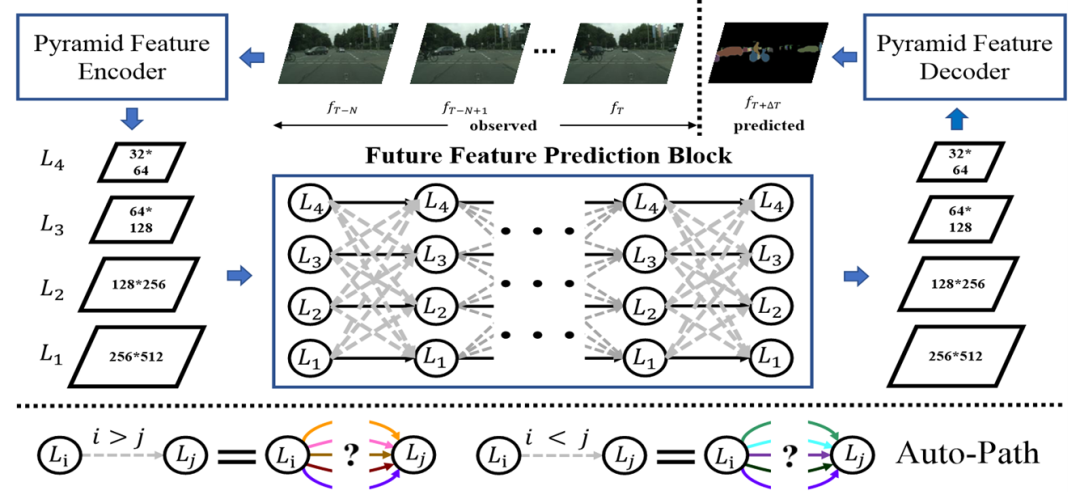

基于多层次特征跨时域特征学习的视频运动生成(未来将要做/发生什么)

为准确分析视频中未来发生什么事情,系统需要观察一小部分行为视频,对剩下未观察视频内容进行精细化的推演与生成,其在现实应用(如自动驾驶和人机交互等)中具有非常重要的意义。例如在自动驾驶系统中,需要提前预测未来一段时间内,视频运动目标将会出现在哪些区域(即精细化的运动推演),才能准确获得让汽车安全行驶的可行驶区域,避免与行人、障碍物碰撞或是行驶到不正确的位置。精细化运动视频生成需要模型同时完成对视频对象精细化的认知识别和未来运动态势预测,其核心挑战在于1)视频时空单元有效特征难提取,时空单元特征间跨时间依赖关系难建模。

针对上述两个挑战,胡建芳研究团队1)搭建了稀疏路径自适应汇聚网络,通过在不同时刻的不同粒度特征之间引入一条可学习的动态网络连接,实现了多层次特征序列跨层次跨时间自适应汇聚;2)设计了行为信息引导的视频生成框架,利用高层的行为语义认知信息约束细粒度视频生成,从而大幅度提升视频运动生成准确率(超8%)。

委员专访

问:请问您的研究领域包括哪些?最近进展如何?

胡建芳:近年来,团队主要聚焦于开展视频内容解析方面的研究,围绕理解视频中人体行为活动,主要展开了视频定位与检测、视频识别和视频预测等具体研究,分别研究视频中人过去做过什么,现在正在做什么和将来要做什么,实现全时域多模态的视频理解。与静态图像不同,视频信息除了具有空间关联,还有时间维度的关联。因此,怎样高效准确地提取视频中时空动态信息是视频相关研究的重要难点。研究团队近期在多模态跨时域视频时空信息挖掘(特别是视频与语言空间在不同层次语义关联)方面做了一些研究,具体研究成果见上述亮点工作介绍。未来研究团队将继续在视频内容解析方面展开研究,具体包括跨模态视频-文本理解,视频生成与编辑,3D运动分析,轻量化视频模型,多模态大模型微调等。

问:在您招收研究生时,一般会倾向于招收具备什么技能的学生?

胡建芳:在招收研究生时,我会着重观察具备以下三个方面能力的学生:1.具有一定的发散思维。能从不同角度较准确地解读相关研究工作,发现相关工作的优点和缺陷,从而突破路径依赖,得到解决问题的新思路新方法。发散性思维是做学术研究的一个非常重要的素养,也是科研中idea的来源。2.团队合作精神。课题组同学是一个小的集体,需要大家经常一起讨论最新科研论文和研究思想,与大家积极分享经验。良好的团队合作和沟通能力,有助于成员在团队项目中发挥积极作用,是推动学术进展的一个重要动力。3.吃苦耐劳。得益于深度学习开源框架和开源代码,视觉研究发展日新月异,每天都有不少的科研成果出现在arxiv上,需要不断的更新自身的知识体系,因此,吃苦耐劳的精神显得非常重要。

胡建芳:胡建芳研究团队积极推动相关研究成果的落地转化,与腾讯、全国海关信息中心广东分中心、广州像素等企事业单位合作将研究成果转化应用于医护人员穿脱防护服智能监测和智慧教育等具体工程应用项目,完成了一项专利成果转化,为安全防疫和实验教育安全等提供了有效的技术保障,推进了相关研究成果在工程领域的应用和发展。

通过结合团队的研究成果“基于多模态特征动态融合的视频行为识别”,解决了穿脱过程中人穿脱防护服和防护用具行为建模问题,研发了面向新冠肺炎的防护用具穿脱流程智能引导系统,开展智能培训,提升培训效率和高风险人群的防护能力。联合广东省传染病定点医院中山大学附属第三医院,依据国家防护服穿脱顺序规范标准进行研发。该系统能识别对象穿脱防护用具的关键动作,识别动作种类不少于20种,能够防止穿戴人跳过关键步骤,并检测每个动作是否完成, 识别率95%以上。该系统于2021年6月开始投入使用,在中山大学附属第三医院岗顶院区、萝岗院区、天河区五个社区卫生服务中心等十余家医院院区和拱北海关进行了部署和使用,助力广州疫情防控。该系统具有侦测人物动作,提示流程错误,语音播报和实时示范等功能,支持轻量级设备上部署,可应用在医疗机构隔离病房和大范围培训教学场景和监测。该系统已经封装成一体机,获评为广州市人工智能应用场景典型案例TOP100(如图4)。

依托国家重点研发项目“多模态自然交互的虚实融合开放式实验教学环境”,结合成果一“基于多模态特征动态融合的视频行为识别”,胡建芳与广州像素数据股份有限公司联合研发了理化生实验操作考试AI评分算法,搭建了融合学习者在学习过程中的行为、生理等模态数据的理化生实验行为识别与打分系统,对学生实验过程中的操作情况进行实时分析与评价。该系统结合了对应实验考纲注意事项,建立多层次、多角度和多模态的实验流程规范以及学习行为评价体系。在广州市中学生理化生真实实验考试的47176个视频测试时,系统在所有得分点均达80%以上的准确率,目前已经在深圳市盐田区进行试点应用,较大降低了人工打分工作量,提升了效率。