CSIG中国图象图形学会-青年委员风采-赵健

发布时间:2024-07-22 16:47:56 人气: 作者:小编

【青年委员风采】- 赵健

简介:赵健,中国电信人工智能研究院多媒体认知学习团队(EVOL Lab)负责人、资深研究科学家,西北工业大学光电与智能研究院研究员、博导,博士毕业于新加坡国立大学。研究领域:多模态AI智能体、临地安防、多媒体分析。围绕无约束视觉目标智能感知与深度理解发表CCF-A类论文60余篇,一作代表作包括2篇T-PAMI (CCF-A, IF: 20.8)、3篇IJCV (CCF-A, IF: 11.6)等,第一发明人授权国家发明专利5项。技术成果服务于多个国家重要部门,同时也在中国电信、百度、蚂蚁金服等7个科技领军企业得到应用,产生了显著效益。主持开源的Anti-UAV (Star 200+, Fork 40+)、face.evoLVe (Star 3k+, Fork 700+)等系列成果被清华计图(Jittor)、百度飞浆(PaddlePaddle)框架官方引入,为国产化开源社区生态建设做出了重要贡献。入选了中国科协、北京市科协“青年人才托举工程”,主持JKW某特区项目、国自然面上/青基等项目7项。曾获吴文俊人工智能优秀青年奖(2023)、吴文俊人工智能自然科学奖一等奖(2/5, 2022)、ACM MM唯一最佳学生论文奖(一作, 1/208, CCF-A, 2018),8次在国际重要科技赛事中夺冠。担任北京图象图形学学会理事,国际知名期刊《Pattern Recognition》、《IET Computer Vision》、《Artificial Intelligence Advances》编委,《Pattern Recognition Letters》、《Electronics》特刊客座编辑,VALSE资深领域主席,ACM Multimedia 2021分论坛主席,CICAI 2022/2023领域主席,CCBR 2024论坛主席,中国人工智能学会/中国图象图形学学会高级会员,“挑战杯”2023/2024大学生科技作品竞赛评委,中国人工智能大赛专家委委员等。

个人主页: https://zhaoj9014.github.io

学院主页: https://iopen.nwpu.edu.cn/info/1252/4626.htm

委员亮点工作介绍

赵健团队以临地安防、公共安全等关键领域重大需求为导向,围绕无约束视觉目标智能感知与深度理解开展了基础研究和实践探索,致力于破解复杂要素耦合空间属性关系挖掘与识别这一核心科学问题,重点研究了多模融合学习态势感知、要素解耦学习属性关联、因果嵌套学习语义理解三个方面:1)多模融合学习态势感知通过有效融合红外、可见光等多源信息的互补优势、互辅助互指引特性,实现视频序列中目标时空位置的实例级检测跟踪;2)要素解耦学习属性关联通过充分挖掘目标的内在属性耦合结构和关联关系,发现不同属性之间的复杂依赖,实现目标身份、类别等属性级信息的识别判断;3)因果嵌套学习语义理解通过逐阶建模复杂场景与由粗到精信息的渐进式反馈,将高复杂度任务向低复杂度子任务分解转化,实现精细化像素级解析。三项工作(实例级→属性级→像素级)相互关联、层层递进,共同支撑不同类型的公共安全实际应用需求。

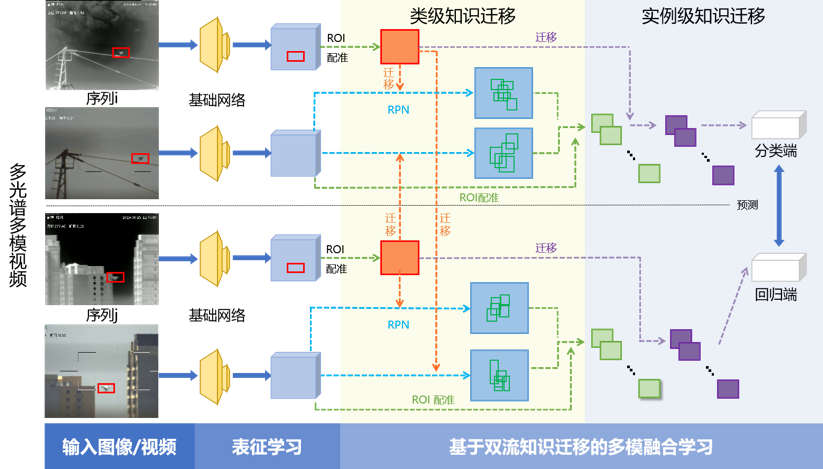

提出双流迁移多模融合实例级目标跟踪创新思路,通过多阶耦合-双流级联,联合感知全局-局部信息,实现多阶信息融合互补、时空线索联动建模和层级知识级联迁移。

态势是关于环境当前状态及其变化趋势的数字化描述,主要包括场景中各参与要素的“态”(历史及当前状态)和“势”(对当前状态及未来变化的判断与预测),获取“态”的信息并预测“势”的信息是临地安防可疑目标态势感知的基础和重点。如为保障某要地低空安全,需对微小型无人机等可疑目标的时空关键信息进行感知,首先需要检测目标的位置、数量等状态信息,随后确定目标的运动轨迹、动作行为等趋势信息,从而得到其综合态势感知的结果。然而,无约束条件下微小型无人机等目标在运动过程中受速度、背景、障碍物等影响,其视觉信息产生多变性,导致目标态势获取不精确。

主要创新:

针对上述挑战,赵健团队提出了基于双流知识迁移的多模融合实例级目标跟踪算法。解决无约束条件下目标跟踪问题的关键在于如何克服目标姿态/视角变化、严重遮挡、瞬时突变和长时渐变等情况下,算法无法有效适应目标表观变化。因此,赵健团队一方面提出将基于注意力机制的双流知识迁移引入到目标跟踪问题中,充分挖掘多光谱多模视频序列中的时空信息和目标运动特征,通过知识双向流动迁移融合,跟踪器可以学习到更强大的类级语义信息并获得更具区分度的实例级表征。如跟踪微小型无人机目标时,当观测情况不良,仅基于可见光单方面无法获得足够有效信息,利用多模融合机制,通过可见光、红外双流知识迁移,有效融合互补信息,实现目标的快速发现和稳定跟踪。另一方面设计了局部跟踪和全局检测相结合的自适应动态目标搜索机制:当目标状态可靠时采用局部跟踪,利用视频时空连续性,有效抑制背景干扰;当目标状态不可靠时(发生完全遮挡、从视野消失等)采用全局检测,结合目标运动特征、历史轨迹锁定候选区域,提高目标再捕获概率。该方法为面向多源信息融合的无约束视觉目标跟踪提供了一个标准化模型,在复杂环境多重遮挡情况下性能取得了超过此前最好方法19.95%的跟踪精度提升。

研究内容2(要素解耦学习属性关联)

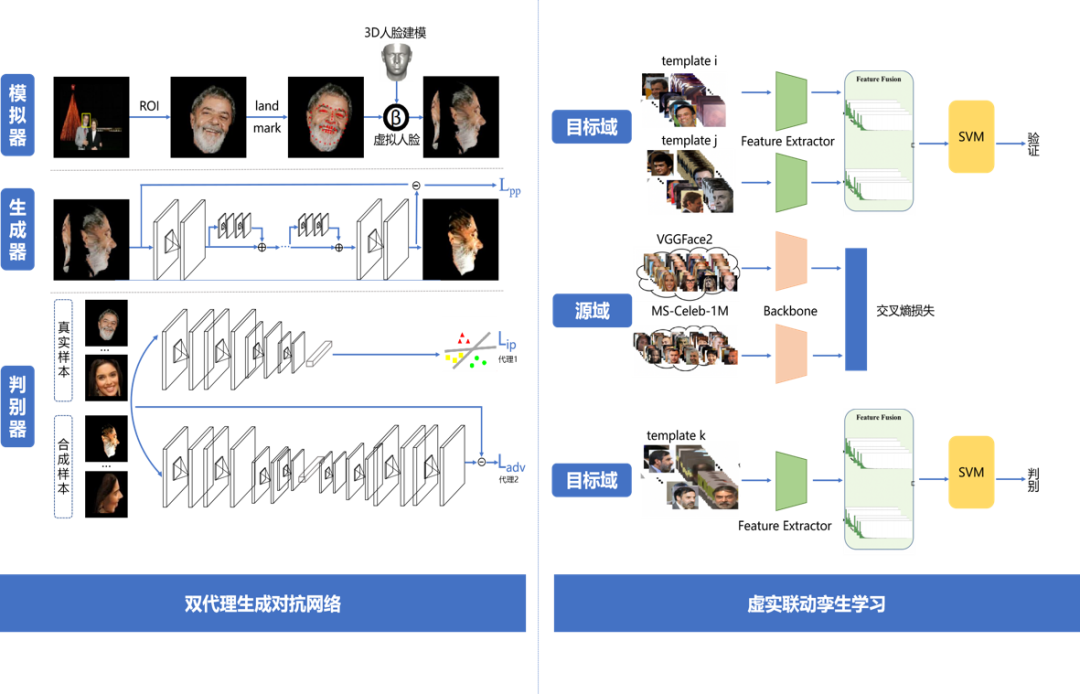

提出归一化学习要素解耦属性级目标识别创新思路,通过多属性依赖关系建模、归一化学习要素解耦,厘清属性耦合结构,实现统一处理诱变因素和各关联属性归一化。

属性是事物的性质和特点,视觉目标的属性主要包括类别、年龄、性别、种族等,获取这些信息是临地安防关注目标属性关联的基础和重点。如某突发公共安全事件中,关注目标通过蒙面、化妆等手段刻意掩盖身份信息实施行动,需对其面部、肢体等关键特征进行综合感知,实现目标身份信息的识别判断,从而实施追查布控。然而,无约束条件下潜在危险目标受表情、步态等内在属性的耦合影响和视角、分辨率等外部因素的干扰影响,其属性结构产生多样性,导致目标属性识别不精准。

主要创新:

针对上述挑战,赵健团队提出了基于归一化学习的要素解耦属性级目标识别算法。解决无约束条件下目标识别问题的关键在于如何发现内在属性和关联关系,厘清复杂属性耦合结构。因此,赵健团队一方面基于创新成果一的多模融合学习态势感知算法,通过挖掘目标表征内在属性和关联关系,发现了不同目标属性之间存在互补性关联、相关性协同和因果性推理三种关联关系,分别用于两个属性之间不存在依赖、存在部分依赖以及存在完全(包含)依赖关系建模,为多任务属性识别提供了理论分析基础和模型设计依据。另一方面通过对抗学习解耦各诱变因素并驱动生成归一化人脸到标准约束空间后再统一识别的全新思路,为无约束人脸识别提供了统一处理各种诱变因素的模型,大幅提升了无约束人脸识别模型综合性能和适用范围,有效缓解了复杂要素耦合空间人像关联属性解耦难题,实现了由“全要素复杂耦合”到“关键要素解耦”推理范式的转变。如识别目标人物身份信息时,种族的差异和性别的不同会影响年龄的判断,而年龄的增长和视角的转变直接影响身份的确认,利用要素解耦机制,通过不同关联属性的归一化学习,有效分解属性结构,实现目标属性的精准识别。该方法为视觉目标属性识别分析提供了求解思路和学习示例,为重点目标语义理解提供了丰富属性集合,在大姿态条件下取得了超过当时最好方法17.1%的识别精度提升。

研究内容3(因果嵌套学习语义理解)

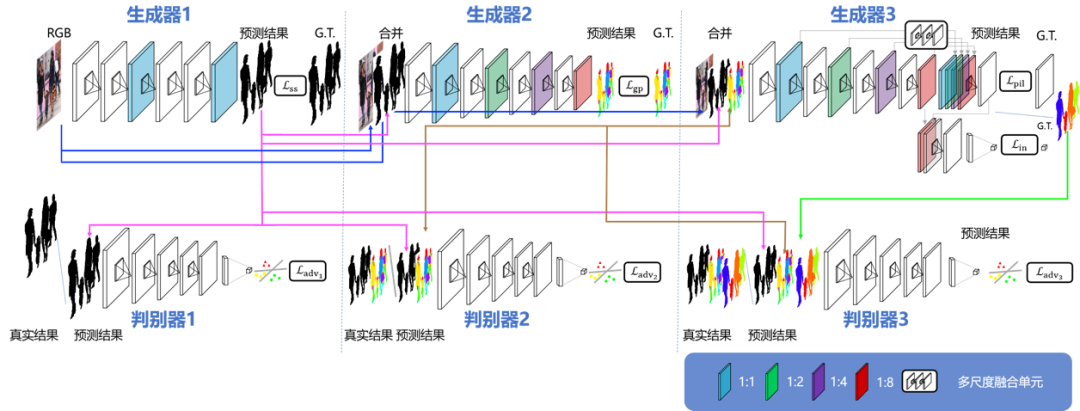

提出局部-全局信息关联因果嵌套像素级目标解析创新思路,通过局部-全局关联、因果嵌套学习,实现特征协同优化、语义因果推理。

语义是图像中能够被人类理解的内容,语义分割是为每个像素分配一个预定义的语义标签,将图像分割为若干个视觉上有意义或关注的区域,相较于目标检测跟踪和属性识别,像素级语义分割有助于更精细化的分析研判,获取这些信息是进行临地安防重点目标语义理解的基础和重点。如某聚集性公共活动中,重点目标藏匿于人群不易发现,需在复杂场景建模的基础上对不同目标的详细特征进行分析,实现目标语义信息的像素级理解,从而实施精细检索研判。然而,无约束条件下人群中的重点目标可能因距离较远轮廓模糊、与人群混杂遮挡严重,其场景复杂产生多元性,导致目标语义理解不精细。

主要创新:

针对上述挑战,赵健团队提出了局部-全局信息关联约束的因果嵌套像素级目标解析算法。解决无约束条件下目标解析问题的关键在于如何提取复杂高维视觉目标数据蕴含的不变性关键信息和约束性局部全局信息关联。因此,赵健团队一方面基于创新成果一的多模融合学习态势感知算法和创新成果二的要素解耦学习属性关联算法,通过分析无约束视觉目标的多变视觉呈现,揭示了不变性关键信息学习之于精细化语义理解的重要性,考虑到局部信息与全局信息既有对应性又有一致性,提出将因果嵌套学习融入多目标场景建模与多粒度多层次语义理解,将像素级目标解析分解转化为语义显著性预测、非实例级解析与实例级聚类三个子任务,形成三个互相依赖的子网络,构成因果嵌套式信息反馈结构并通过对抗学习相互促进。这种嵌套式网络结构有助于保持端到端学习的高效性,确保了解析结果与目标物理结构的空间一致性,实现了算法消耗可承受、算法效能可实用。如在群体中检索目标人物时,各实例相似度较高,部分区域可能产生混淆误判,利用因果嵌套机制,通过不同部位特征的局部-全局关联约束,有效建模场景目标,实现像素级语义的精细解析。该方法为视觉目标语义解析理解提供了求解思路和学习示例,为重点目标画像精细刻画提供了丰富线索集合,相比于此前最好方法,极大提升了细粒度语义解析结果的可解释性、合理性、准确性,将像素级细粒度语义解析的准确率提升了18.9%,推理速度提升了10倍。

图3: 一种局部-全局信息关联的因果嵌套像素级目标解析算法

委员专访

问:我们注意到您目前在中国电信人工智能研究院担任多媒体认知学习团队(EVOL Lab)负责人、资深研究科学家、研究员,能否向大家介绍一下,中国电信人工智能研究院是一个什么样的机构?

7月5日,中国电信人工智能研究院(TeleAI)在2024世界人工智能大会(WAIC 2024)正式揭牌。现场,国务院国资委副主任苟坪,上海市副市长陈杰,图灵奖获得者、美国国家科学院院士、美国国家工程院院士、中国科学院外籍院士John Hopcroft,中国电信集团有限公司董事长柯瑞文,中国电信集团有限公司总经理梁宝俊,中国电信CTO、首席科学家、TeleAI院长李学龙教授出席并见证。

上海市副市长陈杰在致辞中指出,近年来,上海市将人工智能作为重点发展的三大先导产业,出台了若干的推进举措,并将持续完善大模型生态体系建设,包括加大关键核心技术的攻关、加强算力资源的统筹调度、加快大模型的落地赋能应用。欢迎中国电信继续发挥算力+算法+网络+平台+服务的综合优势,为助力打造人工智能世界级的高端产业集群贡献更多的力量。

中国电信集团有限公司董事长柯瑞文表示,中国电信坚定履行建设网络强国和数字中国、维护网信安全的使命责任,将全面推进人工智能融合创新应用和生态开放合作,并致力于把中国电信人工智能研究院(TeleAI)打造成为国家人工智能核心战略科技力量的人才高地。

中国电信集团有限公司总经理梁宝俊表示,中国电信人工智能研究院(TeleAI)将与国内外一流大学、知名企业和研究机构,包括政府部门联合合作,从科学前沿探索到应用技术落地,把中国电信人工智能研究院(TeleAI)打造成为国家人工智能核心战略科技力量的人才高地。

中国电信人工智能研究院(TeleAI)由李学龙教授牵头组建并出任院长。李学龙教授曾获国家和省/部/学会奖励十余项、何梁何利科学与技术创新奖、陈嘉庚青年科学奖、首届全国创新争先奖、CCF-ACM人工智能奖、腾讯科学探索奖等。当选为国际人工智能学会(AAAI)执委(2021-2024)、AAAI Fellow、AAAS Fellow、ACM Fellow、IAPR Fellow、IEEE Fellow、国际宇航科学院院士、欧洲科学院院士,关注人工智能的科技进步、工程能力建设、高端人才培养。

TeleAI作为央企力量,承载国家意志、服务国家需求,依托中国电信在算力、数据、场景、用户等方面的领先优势,持续致力于引领科技创新、驱动产业发展、满足用户需求,助力实体经济提质降本增效,为国家、产业提供更具信任的人工智能基础。

放眼全球,一些科技头部企业在当下的科技创新中发挥着引领作用。TeleAI将时刻对标这些企业,持续锤炼技术能力,打造国内领先、国际一流的科研平台。在科研方向的选择上,TeleAI将探索更具差异化的发展,力求实现用人工智能技术赋能工业的转型升级,加持农业的智慧生产,更促进实体经济的蓬勃昌茂,真正实现将人工智能技术转化为新质生产力,成为引领人工智能技术发展的新时代风向标。

揭牌仪式上,李学龙教授表示,TeleAI将围绕人工智能的“人”、“工”两大要素,打造高质量人才队伍、产出高水平科研成果。

“人”为本,人才的思想力、创造力就是事物的生产力、推动力。TeleAI现已引入多位海外TOP高校的教授、国内知名企业的CTO或科学家、科研机构的青年人才、以及拥有高影响力开源成果的天才学生,志在锻造一支由领军科学家领衔、青年人才担纲、科研新生代引领创新的国际化、年轻化、成体系的人才队伍。

同时,TeleAI着力构建AI人才的海内外双循环体系。一方面,TeleAI将搭建适配人才快速发展的科研平台,吸引海外一流大学、研究机构、头部企业的人才回国,加入TeleAI,为国家的人工智能产业发展提供人才“源动力”。另一方面,TeleAI将逐步扩展在全球的科研力量布局,加强与海内外高校、科研机构、头部企业的科研合作与人才培养,持续夯实与海内外高层次人才的互动、交流、合作、转化。TeleAI将以识才的慧眼、爱才的诚意、用才的胆识、容才的雅量、聚才的良方,为人才提供更大的舞台,做到聚天下英才而用之。

“工”为基,在现有的产业格局中,中国电信的骨干网和卫星通信等等都是空间经济的坚实基础。依托此优势,TeleAI关注AI驱动的赛博空间、临地空间、广域空间等三个空间经济的共性关键技术和理论。在赛博空间,关注大模型、AI Infra、智传网、智能软硬件等技术;在临地空间,关注城市安防、低空经济、自动驾驶、具身智能、工业智能、海洋牧场等;在广域空间,关注商业航天、卫星遥感、深海探测、深空探测等,助力人工智能驱动的产业经济,促进紧跟时代需求的创新科研。

目前,我们正在招贤纳士(全职研究科学家/研究员/访问学者/科研助理/联培生/实习生),诚邀海内外优秀科研工作者加入,一起做“顶天立地”的前沿探索和应用创新,欢迎大家联系zhaoj90@chinatelecom.cn推荐或自荐。

问:您在临地安防、多媒体分析领域围绕“无约束视觉目标智能感知与深度理解”做了很多高水平、有影响力的工作,也取得了很好的应用转化成果,近期您还在关注哪些有价值的方向、进展如何?

最近我们在关注「多模态AI智能体」方向。

人类的发展史实际上一直伴随着「工具」的演变和发展,从人类学会使用火,到石器、青铜器时代,到三次工业革命——蒸汽机、无线电、互联网,再到当前的机器学习、深度学习和大模型,从「人类智能」到「人造智能」,人类一直在追寻某种工具,从而获得某种能力的加持,以便更高效便捷地处理生产生活中的各类活动。智能时代的工具应该是什么?答案可能是「多模态AI智能体」——能够感知外界环境、做出推理决策,采取响应行动的人工实体。多模态AI智能体被认为是实现通用人工智能(Artificial General Intelligence, AGI)的关键,近年来相关的研究和探索正逐渐成为人工智能领域的焦点。

因此,面向民生经济重大需求,我们围绕探究复杂世界中多模态AI智能体的实现机理与应用特性这一科学问题,利用数据和知识混合驱动的多模态多任务多场景智能化工作流这一核心思路方法,开展开放世界下的多模态感知、网络空间下的虚拟智能体、物理空间下的具身智能体和综合场景下的多维度评估等四项内容的研究,提出多模态数据构建与跨模态表征编码对齐算法、基于虚拟智能体的复杂场景多任务智能化工作流、基于具身智能体的多变场景实时感知认知工作流和综合场景下面向多模态AI智能体的多维度评估指标等四点创新,致力突破数据模态多样性、任务流程多向性、环境交互多变性、评估体系多元性等难题。研究内容相互支撑、层层递进,从数据到评估、从虚拟到现实,形成一套完整的多模态AI智能体研究体系,为“AI+”场景和形成新质生产力提供有力支撑。

目前,我们正聚焦「AI for Tour」有序开展技术探索和应用创新,依据出行诉求、习惯喜好、历史信息等,规划衣食住行用等方方面面,构建形影不离、随时可用的个性化智能出行助手,相关学术成果和应用示范将陆续与大家见面,欢迎大家关注我们的主页https://zhaoj9014.github.io。

问:我们注意到在刚刚结束的CCF-A类会议、人工智能领域国际顶级会议CVPR 2024低光目标检测挑战赛上,您团队获得了冠军,我们都知道低光照、高噪声条件下的目标感知理解非常难,而且听说这次比赛共有超90支来自全球各地的队伍参赛,角逐异常激烈,能取得这样的佳绩实属不易,能否给大家介绍一下?

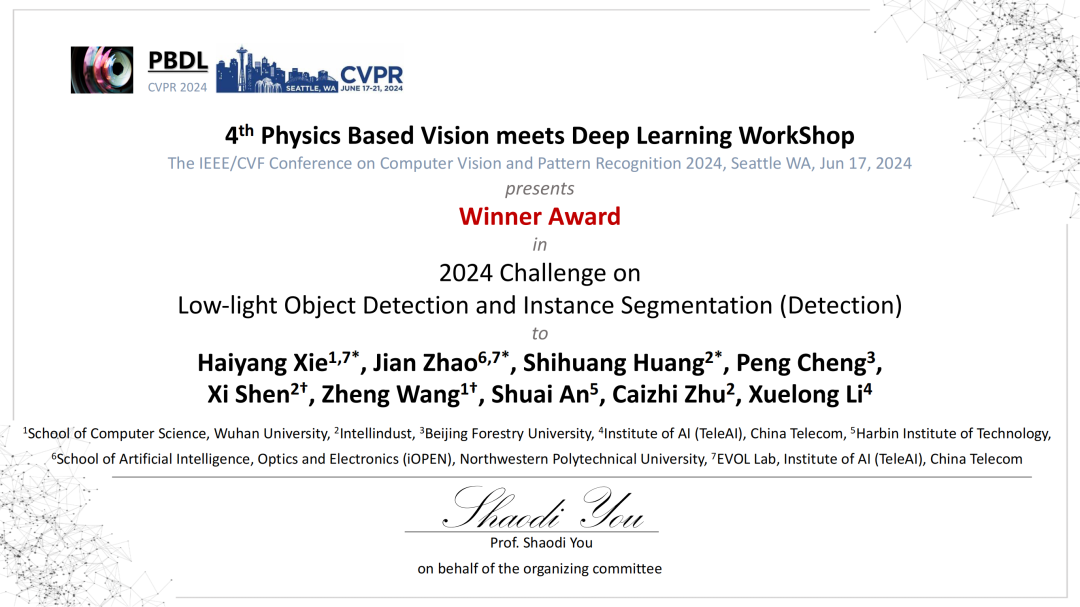

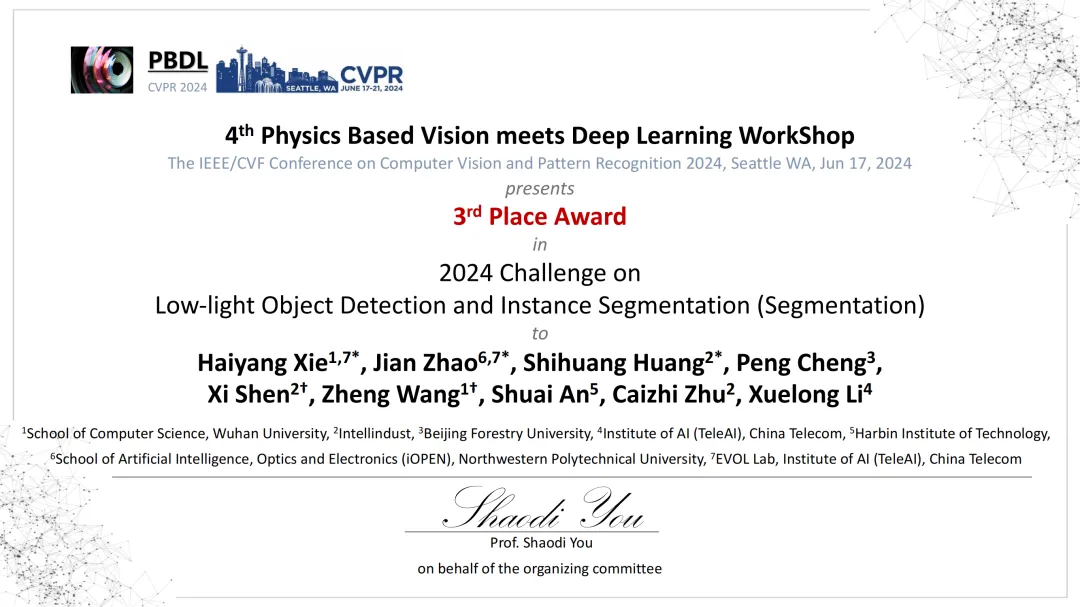

是的,近期李学龙老师带领我们联合武汉大学、英特灵达等单位,在这次比赛上获得了目标检测赛道(Detection Track)冠军及实例分割赛道(Segmentation Track)季军。

国际计算机视觉与模式识别会议(IEEE International Conference on Computer Vision and Pattern Recognition,简称CVPR)是全球顶级的计算机视觉学术会议之一,每年吸引数万名全球顶尖科研学者参与。该会议上,低光目标检测挑战赛(Low-light Object Detection and Instance Segmentation Challenge)由英伟达、北京大学、阿姆斯特丹大学等国内外顶级企业和高校共同组织,吸引了三星、联想等国际企业,清华大学、中国科学技术大学、澳大利亚国立大学等国内外知名高校参与。

作为计算机视觉的经典任务,目标检测与实例分割在临地安防、自动驾驶及医疗影像分析等领域发挥着至关重要的作用。现有算法在夜间、恶劣天气等场景下性能受限,严重影响了其实际应用。本次竞赛聚焦于此,旨在提升现有模型在真实环境中的综合应用效能。竞赛需要参赛模型以低光照和高噪声条件下的图像样本作为输入,输出图像中物体的类别、边界框以及像素级的语义掩码,对参赛团队算法模型的精度、效率提出了极高的要求。

受到脑认知科学与类脑智能的启发,团队首次提出「认知增强学习+多智能体协同决策」的创新方案,极大提升了复杂无约束场景下目标检测和实例分割的性能。

模型对于视觉任务的认知能力往往在很大程度上受制于训练样本的数量和质量。低光照数据采集难度大、复杂度高,目前业界低光照数据资源相对匮乏。常见的RGB图片是RAW数据经过ISP (Image Signal Process)流程进行提亮、去噪和颜色调整等处理后形成的,而原始的RAW数据的亮度低且噪声高。为了降低数据获取难度,匹配模型优化能力,团队利用当前带有高质量标注的RGB图片数据集,针对每个ISP流程设计了相应的逆变换策略,将现有的RGB域的COCO等数据集转变为与比赛开源训练数据集具有相似分布特性的可用数据。逆处理后的数据集经进一步处理后,与比赛数据集耦合作用于模型的学习,让模型“看得更多、见得更广、学得更好”。通过此学习策略,提升了模型的特征表示能力、语义提取能力和跨域泛化能力,从而大大增强了模型的感知理解性能。

受“涌现”现象所带来的性能优势启发,团队在算法中引入多智能体协同决策机制来获得更加准确、鲁棒的目标感知结果。在该机制中,多个智能体之间通过交流与协商,合作完成决策过程,以获得更准确的结果。基于Co-Detr、DINO、RTMDet、YOLO-X等性能领先的目标检测模型,团队从数据算法的多元性、模型优化的多样性和目标尺度的多变性等层面设计了18个智能体模型。每个智能体聚焦于一个检测视角,然后采用加权边界框融合技术(Weighted Box Fusion),让各个智能体“各尽其能、各展所长”地协同决策,最终得到更精确、有效的目标检测结果。

对于实例分割(Segmentation Track),非极大值抑制(Non-Maximum Suppression, NMS)是一个关键的环节,其主要目的是消除冗余候选区域。对于一组候选区域,NMS按照其置信度等指标进行排序,然后依次选择置信度最高的候选区域,并将与其有较大重叠的其他候选区域抑制或去除。在多智能体协同决策的基础上,团队针对NMS逻辑进行了特定设计和优化,使得模型可以输出更多高质量的候选区域提案和更精细化的掩码,从而显著提高模型的实例分割精度。

基于以上创新技术方案,TeleAI团队成功斩获CVPR 2024低光目标检测挑战赛目标检测赛道冠军及实例分割赛道季军。后续团队将在此基础上不断深耕,持续探索前沿技术,赋能应用实践,为自动驾驶、临地安防、多模态AI智能体等方向提供有力支撑。